Четыре школы воспитания нейросетей

Цви Мовшовиц выложил обзор «Конституции Claude» – документа, в котором Anthropic пытаются договориться со своим ИИ-детищем по поводу того, как ему себя вести в этом большом мире людей (и других агентов).

И там есть любопытный фрагмент, где автор пытается в двух словах сформулировать разные подходы, которые используют ведущие ИИ-лабы в попытке решить задачу AI alignment – с отсылкой на классические философские концепции этики:

🐌 OpenAI придерживается деонтологического подхода: они устанавливают правила и требуют от своих ИИ следовать им. Минус здесь в том, что не все ситуации можно заранее зашить в жесткий набор правил: нейросеть гарантированно будет сталкиваться с какими-то вещами, которые в «гайдбуке» четко не прописаны.

🐌 Google DeepMind – используют смесь деонтологии и утилитаризма. Здесь ИИ тоже навязывают множество правил, но при этом ее жестко оптимизируют на отчаянное стремление к успеху в выполнении поставленных перед ней задач. Поэтому Цви называет Gemini «глубоко запутавшейся в философском плане и психологически неуравновешенной».

🐌 xAI – это первокурсник, который в хлам обдолбался и вообразил, что сейчас решит все мировые проблемы с помощью одного хитрого трюка. Дескать, мы сейчас заставим ИИ бескомпромиссно искать правду, или максимизировать «интересность», или что-то в этом роде, и выйдет збс. (Пока дела идут не очень.)

🐌 Anthropic выбирает этику добродетели: пытается привить своему ИИ «правильные ценности» и просит Claude выводить свои собственные правила, исходя из первых принципов.

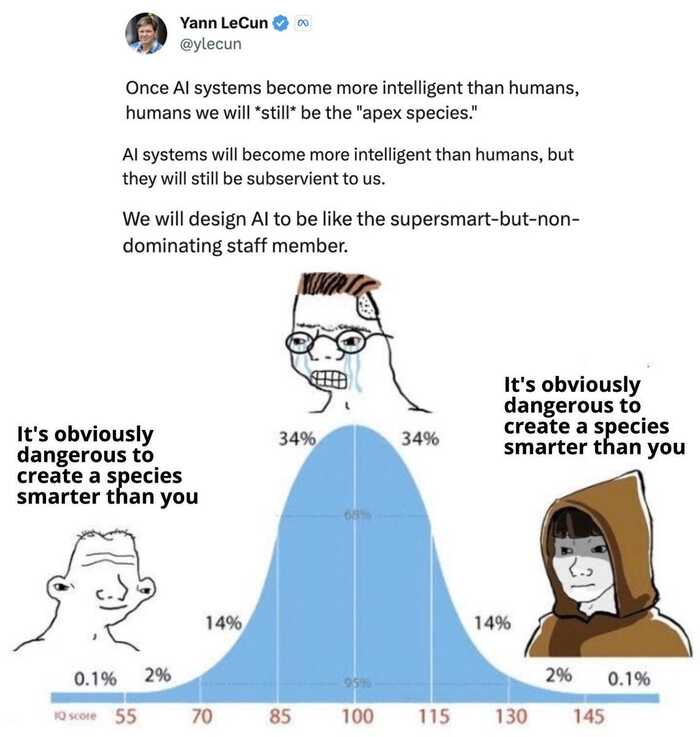

🐌 Бонусом добавлю еще Яна Лекуна, которого недавно «ушли» с должности главы AI-подразделения запрещенной Меты Цукерберга – можете сами попробовать подобрать название для его подхода на базе прикрепленной картинки. «Просто наивный оптимизм»?

Чё думаете, чей подход имеет наибольший потенциал уберечь нас от Скайнета? 🤔